🎁Calendrier de l'Avent Spécial Data Science - Jour 24 Les indicateurs à maîtriser lorsqu'on fait de la classification

[💡 Info avant de démarrer : Hier, durant le WAS22, nous avons parlé d'analyse de la variance. Le replay est disponible dans la vidéo ci-dessous. L'ensemble des ressources du live est disponible ici : https://github.com/LeCoinStat/WAS/tree/main/WAS22]

Le replay est disponible ici:

Maintenant place à la surprise du jour 24

Voici le programme de la journée :

- Les 7 indicateurs à maîtriser lorsqu'on fait un modèle de classification

- Le quiz pour évaluer vos connaissances.

Les 7 indicateurs à maîtriser lorsqu'on fait un modèle de classification

En machine learning, lorsqu'on parle de classification, on fait référence au modèle ayant comme variable d'intérêt une variable qualitative. Pour évaluer les performances d'une classification, voici les 7 indicateurs les plus utilisés.

1. Courbe ROC et AUC

- Définition: La courbe ROC (Receiver Operating Characteristic) est un graphique qui illustre la capacité d'un modèle de classification à distinguer entre les classes. L'AUC (Area Under the Curve) est la mesure de l'aire sous la courbe ROC.

- Interprétation: Une courbe ROC plus proche du coin supérieur gauche indique une meilleure performance. Une AUC proche de 1 signifie une excellente capacité de distinction entre les classes. L'AUC de 80 % signifie que si je choisis deux individus aléatoires, le modèle sera capable de bien classer ces deux individus dans 80 % des cas..

- Limites: La courbe ROC et l'AUC peuvent être trompeuses dans des situations où les données sont très déséquilibrées. Elles ne tiennent pas compte du coût des différents types d'erreurs.

2. Matrice de Confusion

- Définition: Tableau qui montre les vrais positifs, vrais négatifs, faux positifs et faux négatifs d'un modèle de classification.

- Interprétation: Permet d'évaluer la précision du modèle en distinguant les types d'erreurs commises.

- Limites: Ne fournit d'informations sur le fonctionnement du modèle à différents seuils.

|

3. Exactitude (Accuracy)

- Définition: Proportion des prédictions correctes par rapport au total des prédictions.

- Interprétation: Mesure globale de la performance du modèle.

- Limites: Peut être trompeuse dans les cas de déséquilibre des classes, favorisant la classe majoritaire.

4. Précision (Precision)

- Définition: Proportion des vrais positifs parmi toutes les prédictions positives.

- Utilité: Utile lorsque le coût des faux positifs est élevé.

- Limites: Peut ignorer une grande partie des vrais positifs (faible rappel), surtout dans des classes déséquilibrées.

5. Rappel (Recall)

- Définition: Proportion des vrais positifs par rapport au nombre total de cas réels positifs.

- Utilité: Important dans les situations où manquer un positif réel est critique.

- Limites: Peut conduire à une augmentation des faux positifs.

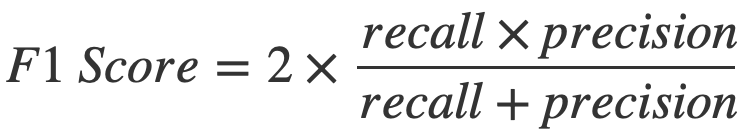

6. Score F1

- Définition: Moyenne harmonique de la précision et du rappel.

- Utilité: Donne un équilibre entre précision et rappel, particulièrement dans des situations où ces deux mesures sont importantes.

- Limites: Peut ne pas être informatif dans des contextes où un des aspects (précision ou rappel) est nettement plus important.

|

7. Sensibilité et Spécificité

- Définition: La sensibilité (rappel) mesure la capacité de détecter les positifs, tandis que la spécificité mesure la capacité de détecter les négatifs.

- Utilité: Utile pour évaluer la capacité du modèle à identifier correctement les différentes classes.

- Limites: Comme le rappel, la sensibilité peut conduire à une augmentation des faux positifs, tandis que la spécificité peut augmenter les faux négatifs.

Pour passer de 0 à 1 en data science vous pouvez suivre les vidéos du challenge #100JoursDeML

Le Quiz du jour

Question 1: Quelle métrique est la plus appropriée pour évaluer un modèle de classification lorsque les classes sont très déséquilibrées ?

- a) Exactitude (Accuracy)

- b) Score F1

- c) Courbe ROC et AUC

Question 2: Quel est le principal avantage de l'utilisation de la courbe ROC et de l'AUC pour évaluer un modèle de classification ?

- a) Elles fournissent une mesure unique de la performance du modèle.

- b) Elles montrent la capacité du modèle à distinguer entre les classes à différents seuils de classification.

- c) Elles donnent des informations détaillées sur les types d'erreurs commises par le modèle.

Question 3: Dans une matrice de confusion, que représentent les "faux positifs" ?

- a) Les instances où le modèle prédit correctement la classe positive.

- b) Les instances où le modèle prédit incorrectement la classe négative comme positive.

- c) Les instances où le modèle manque de prédire la classe positive.

🎉 Félicitations et Conclusion

Nous voici au terme de notre Calendrier de l'Avent spécial Data Science. J'espère que ces 24 jours vous ont été enrichissants et que les informations partagées vous seront utiles pour vos futurs projets.

Un grand merci pour votre engagement, votre curiosité et vos retours positifs. Merci également à tous ceux et celles qui ont participé aux quiz par email tout au long de ce calendrier. J'espère que cette expérience a été aussi agréable pour vous qu'elle l'a été pour moi.

Je vous souhaite à tous de très belles fêtes de fin d'année. Restez curieux, continuez à apprendre et n'oubliez pas : la connaissance s'enrichit lorsqu'elle est partagée. N'hésitez pas à partager les articles autour de vous. Vous pouvez les retrouver à tout moment en cliquant ici : https://natacha-njongwa-yepnga.ck.page/profile.

À très bientôt pour de nouvelles aventures en data science !

Let's go!

Natacha

Natacha NJONGWA YEPNGA

Hello Reader, Comment allez-vous ? De mon côté, les trois derniers mois ont été particulièrement difficiles. Ma mission de freelance s’est arrêtée brutalement. Je ne m’y attendais pas. Et pour être honnête, je n’étais pas prête. J’ai ressenti une sorte de vide un mélange d’incompréhension, de colère et de peur. Je vous avoue que j’ai encore les larmes aux yeux quand je repense à cet épisode. Alors, sans vraiment réfléchir, j’ai décidé d’arrêter d’être freelance. Je me suis dit que j’allais me...

Hello Reader, Il y a deux jours, j’ai lu un post de Steven Bartlett que j’ai trouvé fascinant.Je voulais le partager avec vous : “The most important people in my team are the self-educators. The people I promote fastest aren’t the ones with the best CVs, but those I find late on a Friday, teaching themselves something nobody asked them to learn.” Et je crois qu’il a mis le doigt sur la compétence la plus rare aujourd’hui : celle de ne pas attendre qu’on vous dise d’apprendre. Thème :...

Hello Reader, Avez-vous suivi les récentes annonces dans la tech ? Quelque chose est en train de se produire sur le marché du travail. Ce n’est pas une révolution visible du jour au lendemain, mais une transformation lente, profonde et irréversible de notre économie. Les chiffres sont glaçants. Accenture a supprimé 12 000 postes, UPS 48 000, Amazon prévoit jusqu’à 30 000 licenciements selon Reuters, Intel 24 000, Nestlé 16 000 — dont 12 000 cols blancs. Même Goldman Sachs estime que l’IA...